Хоча файли robots.txt є більш технічною частиною SEO-оптимізації, вони є чудовим способом покращити сканування та індексацію вашого веб-сайту.

У цій статті буде розібрано всі деталі, пов’язані з robots.txt, і висвітлено поширені проблеми, пов’язані з його впровадженням.

Якщо ви запустите пошукову перевірку в програмі аудиту сайтів SearchAtlas, ви можете побачити позначені проблеми, пов’язані з вашим файлом robots.txt. Ви можете скористатися цією статтею, щоб усунути та вирішити ці проблеми.

Що таке файли robots.txt?

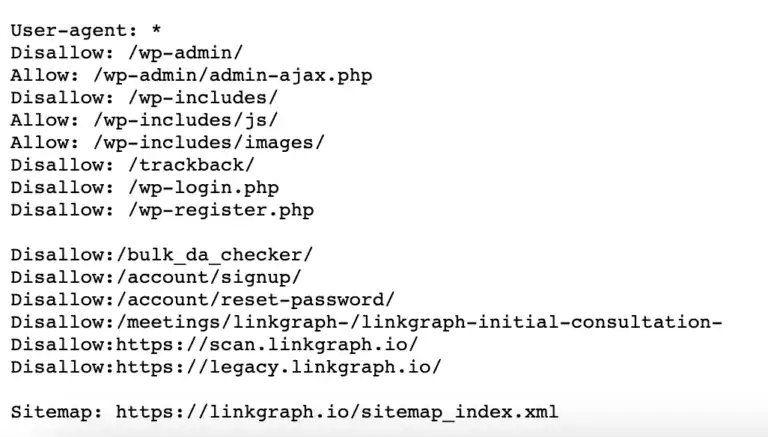

Файл robots.txt повідомляє веб-сканерам, до яких областей вашого веб-сайту їм дозволено доступ, а до яких заборонено. Він містить список рядків агента користувача (ім’я бота), директиву robots і шляхи (URL-адреси), до яких роботі заборонено доступ.

Коли ви створюєте веб-сайт, ви можете обмежити доступ до певних сторінок сторінок вашої пошукової системи та запобігти індексуванню певних сторінок. Ваш файл Robots.txt – це місце, де веб-сканери зрозуміють, де вони мають, а де не мають доступу.

Robots.txt — це хороший спосіб захистити конфіденційність вашого сайту або запобігти індексуванню пошуковими системами вмісту, який не відповідає рейтингу або не готовий для загального використання.

Крім того, якщо ви не хочете, щоб до вашого веб-сайту отримували доступ інші поширені веб-сканери, як-от Applebot, Ahrefbots чи інші, ви можете заборонити їм сканувати ваші сторінки за допомогою файлу robots.txt.

Де знаходиться мій файл robots.txt?

Файл robots.txt — це текстовий файл, який розміщується в кореневому каталозі веб-сайту. Якщо у вас ще немає файлу robots.txt, вам потрібно буде завантажити його на свій сайт.

Якщо веб-сканер не може знайти файл robots.txt у кореневому каталозі вашого веб-сайту, він вважатиме, що файлу немає, і продовжить сканування всіх ваших веб-сторінок, доступних за посиланнями.

Спосіб завантаження файлу залежатиме від вашого веб-сайту та архітектури сервера. Можливо, для цього вам знадобиться зв’язатися зі своїм хостинг-провайдером.

Якщо ви хочете, щоб наша команда LinkGraph налаштувала або завантажила robots.txt для вашого веб-сайту, замовте наш пакет Technical SEO Fundamentals у конструкторі замовлень.

Чому я маю піклуватися про robots.txt?

Файл robots.txt вважається фундаментальною частиною передової технічної практики SEO.

чому Оскільки пошукові системи виявляють і розуміють наші веб-сайти виключно за допомогою своїх сканерів. Файл robots.txt є найкращим способом безпосереднього зв’язку з цими сканерами.

Ось деякі з основних переваг robots.txt:

- Покращена ефективність сканування

- Запобігайте індексуванню менш цінних сторінок (наприклад, сторінок подяки, сторінок підтвердження тощо)

- Запобігає дублюванню вмісту та будь-яким покаранням, як результат

- Зберігає вміст подалі від шукачів, який не обов’язково має високу цінність

Як працює robots.txt?

Коли робот пошукової системи стикається з файлом robots.txt, він читає його та виконує вказівки.

Наприклад, якщо Googlebot натрапить на наступне у файлі robots.txt:

User-agent: googlebot

Disallow: /confirmation-page/

Він також не зможе отримати доступ до сторінки для сканування та індексування. Він також не матиме доступу до жодної іншої сторінки в цьому підкаталозі, зокрема:

- /confirmation-page/meeting/

- /сторінка-підтвердження/замовлення/

- /confirmation-page/demo/

Якщо URL-адреса не вказана у файлі robots.txt, робот може вільно сканувати сторінку, як зазвичай.

Найкращі методи роботи з robots.txt

Ось найважливіші речі, про які слід пам’ятати під час впровадження robots.txt:

- robots.txt є текстовим файлом, тому він має бути закодований у форматі UTF-8

- robots.txt чутливий до регістру, і файл повинен мати назву “robots.txt”

- Файл robots.txt має бути розміщено в кореневому каталозі вашого сайту

- Найкраще мати лише один файл robots.txt у вашому (суб)доміні

- Ви можете мати лише одну групу директив для агента користувача

- Будьте якомога точнішими, щоб уникнути випадкового блокування доступу до цілих областей вашого веб-сайту, наприклад, блокування всього підкаталогу, а не лише певної сторінки, розташованої в цьому підкаталозі.

- Не використовуйте директиву noindex у файлі robots.txt

- robots.txt є загальнодоступним, тому переконайтеся, що ваш файл не відкриває цікавим або зловмисним користувачам конфіденційні частини вашого веб-сайту

- robots.txt не замінює належне налаштування тегів robots на кожній окремій веб-сторінці

Поширені проблеми, пов’язані з robots.txt

Що стосується сканерів веб-сайтів, є деякі поширені проблеми, які виникають, коли файл robots.txt сайту не налаштовано належним чином.

Ось деякі з найпоширеніших випадків, які будуть позначені вашим звітом про аудит сайту SearchAtlas, якщо вони присутні на вашому веб-сайті.

1. robots.txt відсутній

Ця проблема буде позначена, якщо у вас немає файлу robots.txt або якщо він розташований не в правильному місці.

Щоб вирішити цю проблему, вам потрібно буде просто створити robots.txt, а потім додати його до кореневого каталогу вашого веб-сайту.

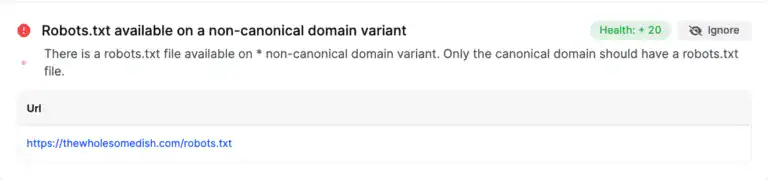

2. robots.txt присутній у неканонічному варіанті домену

Щоб дотримуватися передових методів роботи з robots.txt, ви повинні мати лише один файл robotxt.txt для (суб)домену, де розміщено файл.

Якщо у вас є файл robots.txt, розташований у (суб)доміні, який не є канонічним варіантом, він буде позначений у програмі аудиту сайту.

Неканонічні варіанти домену – це ті сторінки, які вважаються дублікатами сторінок або копіями головних сторінок на вашому веб-сайті. Якщо ваші канонічні теги відформатовано належним чином, канонічним доменом вважатиметься лише головна версія сторінки, і це версія сторінки, на якій має бути розташований ваш файл.

Наприклад, припустимо, що ваш канонічний варіант

Ваш файл robots повинен знаходитися за адресою:

- https://www.website.com/robots.txt

Навпаки, він не повинен розташовуватися за адресою:

- https://website.com/robots.txt

- http://website.com/robots.txt

Щоб вирішити цю проблему, потрібно оновити розташування файлу robots.txt. Або вам потрібно буде 301 переспрямувати інші неканонічні варіанти robots.txt на фактичну канонічну версію.

3. Недійсні директиви або синтаксис, включений у robots.txt

Включення недійсних директив або синтаксису robots може призвести до того, що сканери все одно матимуть доступ до непотрібних сторінок.

Якщо аудитор сайту виявить недійсні директиви у вашому robots.txt, він покаже вам список конкретних директив, які містять помилки.

Вирішення цієї проблеми передбачає редагування файлу robots.txt для включення відповідних директив і належного форматування.

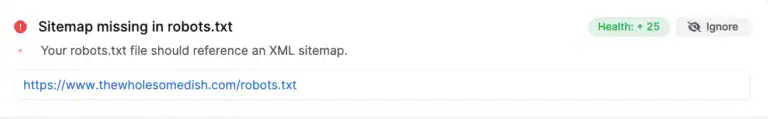

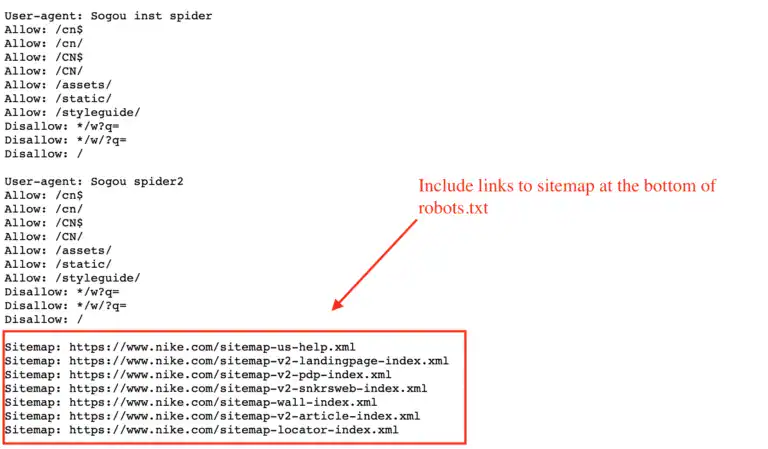

4. robots.txt має посилатися на доступну карту сайту

Вважається найкращою практикою посилатися на XML-карту сайту внизу файлу robots.txt. Це допомагає роботам пошукових систем легко знайти вашу карту сайту.

Якщо на вашу XML-карту сайту немає посилання у файлі robots, вона буде позначена таким повідомленням у програмі Site Auditor.

Щоб вирішити проблему, додайте посилання на карту сайту внизу текстового файлу.

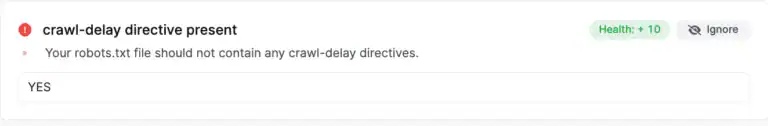

5. robots.txt не повинен містити директиву сканування

Директива затримки сканування наказує деяким пошуковим системам уповільнити сканування, що призводить до того, що новий вміст і оновлення вмісту збираються пізніше.

Це небажано, оскільки ви хочете, щоб пошукові системи якнайшвидше помітили зміни на вашому веб-сайті.

З цієї причини аудитор сайту SearchAtlas позначатиме файл robots.txt, який містить директиву сканування.

Висновок

Правильно налаштований файл robots.txt може дуже вплинути на ваше SEO. Однак вірно й протилежне. Робіть robots.txt неправильно, і ви можете створити величезні проблеми для ефективності SEO.

Отже, якщо ви не впевнені, можливо, найкраще попрацювати з професіоналами, щоб правильно налаштувати файл robots.txt. Зв’яжіться з одним із наших спеціалістів із SEO, щоб дізнатися більше про наші технічні послуги з пошукової оптимізації.